Il 21 ° secolo ha visto l'IA (Intelligenza Artificiale) svolgere compiti come sconfiggere facilmente gli umani a scacchi o insegnare loro rapidamente le lingue straniere.

Un compito più avanzato per il computer sarebbe prevedere la probabilità di un criminale di commettere un altro crimine. Questo è il compito di un sistema di intelligenza artificiale chiamato COMPAS (Correctional Offender Management Profiling for Alternative Sanctions). Ma si scopre che quello strumento non è migliore di un ragazzo medio e può anche essere razzista. Bene, questo è esattamente ciò che un team di ricerca ha scoperto dopo aver studiato a fondo il sistema di intelligenza artificiale ampiamente utilizzato dalle istituzioni giudiziarie.

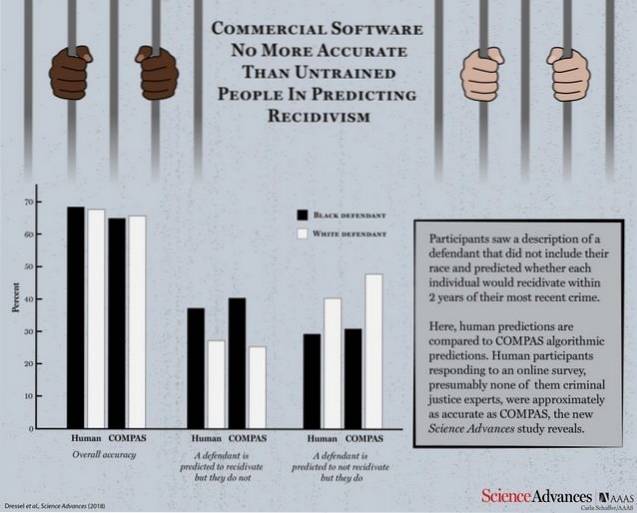

Secondo un documento di ricerca pubblicato da Science Advances, COMPAS è stato confrontato con un gruppo di partecipanti umani per testare la sua efficienza e verificare quanto se la cava con le previsioni logiche fatte da una persona normale. Alla macchina e ai partecipanti umani sono state fornite 1000 descrizioni di test contenenti età, crimini precedenti, sesso ecc. Di autori di reato la cui probabilità di ripetizione dei crimini doveva essere prevista.

Con una quantità di informazioni notevolmente inferiore rispetto a COMPAS (solo 7 funzioni rispetto a 137 di COMPAS), una piccola folla di non esperti è accurata quanto COMPAS nel prevedere la recidività.

COMPAS ha registrato un'accuratezza complessiva del 65,4% nella previsione della recidiva (la tendenza di un criminale condannato a recidivare), che è inferiore all'accuratezza della previsione collettiva dei partecipanti umani pari al 67%.

Ora prenditi un momento e rifletti nella tua mente che il sistema di intelligenza artificiale, che non è migliore di una persona media, è stato utilizzato dai tribunali per prevedere la recidività.

Il software commerciale ampiamente utilizzato per prevedere la recidività non è più accurato o corretto delle previsioni di persone con poca o nessuna esperienza in materia di giustizia penale che hanno risposto a un sondaggio online.

Quel che è ancora peggio è il fatto che il sistema è risultato altrettanto suscettibile al pregiudizio razziale quanto le sue controparti umane quando è stato chiesto loro di prevedere la probabilità di recidiva dalle descrizioni che contenevano anche informazioni razziali dei delinquenti. Non dovresti essere troppo sorpreso lì, poiché è noto che l'IA assume i modelli che i suoi insegnanti umani la programmeranno per imparare.

Sebbene entrambi i lati siano drasticamente al di sotto del raggiungimento di un punteggio di accuratezza accettabile, il punto di utilizzare uno strumento di intelligenza artificiale che non è migliore di un essere umano medio solleva molte domande.

Gadgetshowto

Gadgetshowto