La nostra esperienza diretta con la tecnologia di riconoscimento delle immagini AI, Google Lens, ha dimostrato che l'apprendimento automatico ha sicuramente fatto molta strada. Ma questa tecnologia è attualmente lungi dall'essere perfetta e non così intelligente come speravamo, soprattutto perché il ritmo con cui addestriamo i computer per identificare i modelli è lento. Inoltre, alcune IA richiedono calcoli avanzati per la rete neurale e non è certamente il compito più semplice insegnare a una macchina.

Tenendo presente questo, un gruppo di ricercatori di Google si è assunto la responsabilità di mettere alla prova i sistemi di riconoscimento delle immagini AI e vedere se possono essere ingannati o meno.

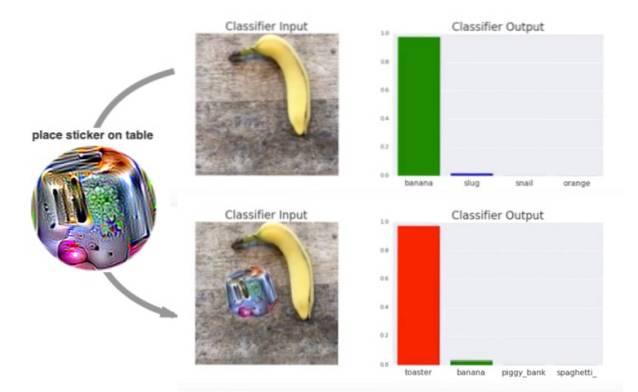

Sembra che siano usciti vittoriosi dal Il sistema AI non è riuscito a riconoscere l'oggetto (qui, una banana) nelle immagini campione, tutto grazie a un adesivo psichedelico appositamente stampato.

La creazione di questi adesivi psichedelici che possono ingannare i sistemi di riconoscimento delle immagini come descritto in un documento di ricerca intitolato Adversarial Patch, che è stato appena presentato alla 31a conferenza sui sistemi di elaborazione delle informazioni neurali nel dicembre 2017. Il documento spiega che i ricercatori hanno addestrato un sistema avversario (avversario) per creare piccoli cerchi psichedelici simili a macchie con forme, colori e dimensioni casuali per ingannare il riconoscimento delle immagini sistema.

Mentre il metodo più comune per ingannare i sistemi di riconoscimento delle immagini AI è alterare un'immagine aggiungendovi dei grafici, i ricercatori di Google hanno deciso di ingannare il sistema con disegni psichedelici.

Come si vede nel video demo qui sotto, il sistema è in grado di riconoscere la banana e, in una certa misura, il tostapane quando si posiziona un'immagine normale accanto alla banana. Ma i risultati sono meno chiari quando un vortice psichedelico viene posizionato accanto alla banana:

Il team ha anche scoperto che a il disegno rattoppato appare separato dal soggetto e non è influenzato da fattori come condizioni di illuminazione, angoli di ripresa, oggetti nella vista del classificatore e il classificatore stesso.

I ricercatori proseguono spiegando il funzionamento dei disegni psichedelici:

Questo attacco genera una patch indipendente dall'immagine che è estremamente importante per una rete neurale. Questa patch può quindi essere posizionata ovunque all'interno del campo visivo del classificatore e fa sì che il classificatore emetta una classe mirata.

Anche se a prima vista sembra che il riconoscimento delle immagini AI sia stato ingannato, questo esperimento verrà effettivamente utilizzato per rimuovere le incongruenze nel sistema. Coloro che lavorano in questo campo devono ora adattarsi ai dati rumorosi che possono essere inclusi nelle immagini dei soggetti. Questa scoperta potrebbe dare ai sistemi basati sull'apprendimento automatico la possibilità di migliorarsi contro simili inganni in futuro.

Gadgetshowto

Gadgetshowto