Google Maps è ovviamente l'app di navigazione e mappe più popolare, non solo su Android ma anche su iOS. È l'app ideale per ottenere indicazioni stradali e cercare pompe di benzina, ristoranti o ospedali nelle vicinanze. Tuttavia, un utente di Twitter si è imbattuto in una query di ricerca dispregiativa che mette in discussione l'algoritmo di ricerca di Google, soprattutto perché lascia i bambini piccoli vulnerabili.

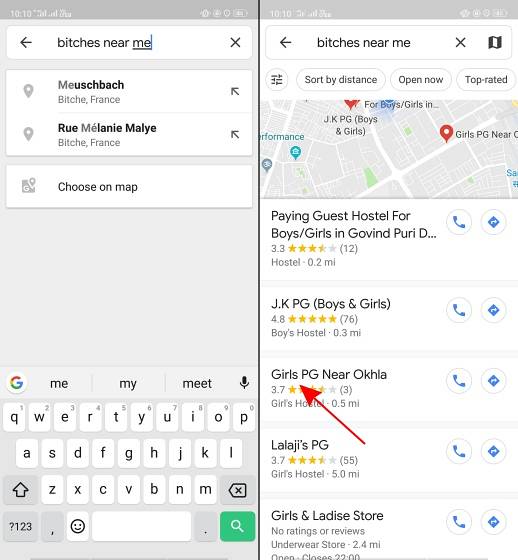

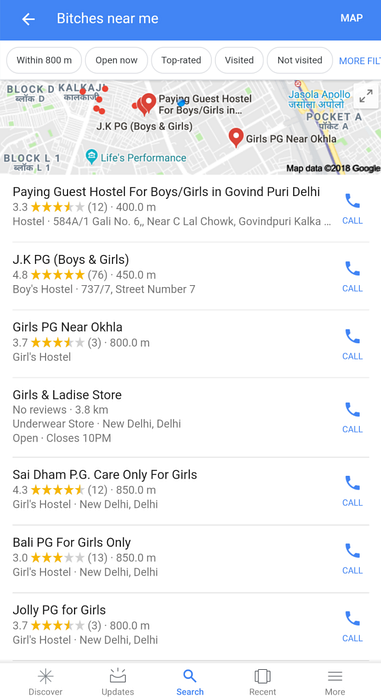

Come riportato dall'utente Twitter @AHappyChipmunk, se apri Google Maps e cerchi "femmine vicino a me", il risultato della ricerca è terrificante. La piattaforma riprende questo gergo dispregiativo (che condanniamo) e mostra scuole femminili, college, ostelli e appartamenti per ospiti paganti, il che ti fa fermare un secondo. In un paese come l'India, dove la parola dispregiativa N è usata da fasce ignoranti della popolazione per mettersi in mostra, i termini di ricerca come le femmine non sono difficili da immaginare.

Google, puoi spiegare perché esiste questo fottuto pic.twitter.com/w0eslFoVSz

- 🌻compañero avalakki ✨ (@Woolfingitdown) 25 novembre 2018

Questo tweet è una terribile sorpresa, ma vedere il logo di un account Twitter di troll (@trollenku) mi ha reso scettico nei confronti del tweet di cui sopra, e inizialmente ho pensato che fosse uno scherzo. Solo utilizzando noi stessi la stessa query di ricerca ci siamo resi conto che non si tratta solo di scuole: l'algoritmo di Google restituisce ogni luogo vicino a te correlato alle ragazze, inclusi gli affitti per sole ragazze e altri ostelli.

Lo stesso vale per le ricerche su Google per quella frase:

Bisogna capire che nessuno in Google è responsabile di questo. L'algoritmo di Google sembra correlare le femmine alle ragazze, il che mette ancora una volta in discussione il pregiudizio dell'IA. Dopo tutto una macchina imparerà solo quello che le insegni.

Il il risultato della ricerca mostra il lato oscuro dell'IA e come la cultura pop possa condizionarti ad associare determinati termini a un particolare genere. Evidenzia anche come pensano le persone che creano questi algoritmi di ricerca. Google dovrebbe essere particolarmente cauto dopo l'abbandono di massa dei dipendenti relativo alle molestie sessuali nei suoi uffici all'inizio di questo mese. La presunta "cultura del fratello" di Google si è anche guadagnata una o due azioni legali. E questa ultima gaffe dell'IA arriva in un momento in cui la visibilità è amplificata grazie al movimento #MeToo in India.

Molte persone hanno twittato a Google per ulteriori informazioni su questo errore di algoritmo. Ti forniremo l'aggiornamento una volta che avremo ricevuto una risposta dalla società.

Gadgetshowto

Gadgetshowto